موتور جستجو چیست؟

موتور جستجو به برنامه ای گفته می شود که کلمات کلیدی موجود در فایل ها وسندها و آرشیوهای FTP و گروه های خبری و..... را جست وجو می نماید . هر کدام از موتورهای جست وجو برای تکمیل فهرست خود از روش خاصی استفاده می نمایند. بهینه سازی سایت برای موتورهای جست وجو یکی از مواردی است که امروزه مورد توجه مدیران سایت ها قرار گرفته است .موتور جستجوی وب یک سیستم نرم افزاری است که برای جستجوی اطلاعات در شبکه جهانی وب طراحی شده است. نتایج جستجو به طور کلی در یک خط از نتایج ارائه می شود که اغلب به عنوان صفحات نتایج موتورهای جستجو (SERPs) نامیده می شود. اطلاعات ممکن است ترکیبی از صفحات وب، تصاویر و انواع دیگر فایل ها باشد. همچنین برخی از موتورهای جستجو، داده های موجود در پایگاه های داده یا دایرکتوری های باز را در دسترس دارند. بر خلاف دایرکتوری های وب که تنها توسط ویراستاران انسانی نگهداری می شوند، موتورهای جستجو با استفاده از یک الگوریتم در یک پایشگر وب، اطلاعات بلادرنگ را حفظ می کنند. محتوای اینترنتی که توسط موتور جستجوی وب قابل جستجو نیست عموما به عنوان deep web توصیف می شود.

آغاز کار موتورهای جستجوی اینترنتی دسامبر سال 1990 پیش بینی شده بود. اما جستجوی کاربران از سال 1982 آغاز شد، و جستجوی سرویس اطلاعاتی Knowbot برای اولین بار در سال 1989 اجرا شد. اولین موتور جستجو مستقل که فایل های محتوا یا به عبارتی FTP را جستجو می کرد، Archie بود که در تاریخ 10 سپتامبر 1990 عرضه شد. قبل از سپتامبر 1993، World Wide Web به طور کامل لیست بندی شد. یک لیست از وب سرورهای ویرایش شده توسط تیم برنرز لی و میزبانی وب سرور CERN وجود داشت. یک تصویر تاریخی از لیست در سال 1992 باقی مانده است، اما هرچه وب سرور های بیشتری آنلاین می شدند، نگهداری لیست مرکزی دشوارتر می شد. در سایت NCSA، سرورهای جدید تحت عنوان "تازه چه خبر" منتشر شد.

حدود سال 2000، موتور جستجوی گوگل به برجسته سازی رسید. این شرکت با نوآوری به نام PageRank برای جستجو به نتایج بهتری دست یافت. این الگوریتم صفحات وب را براساس تعداد و امتیاز سایر وب سایت ها و صفحاتی که به آن لینک می دهند، رتبه بندی می کرد.

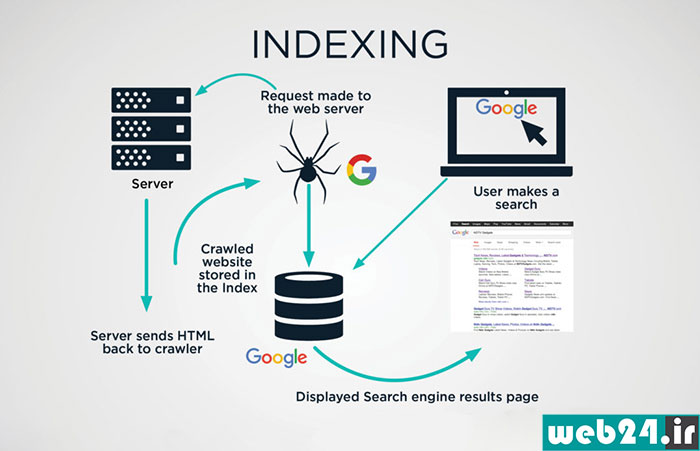

نحوه کار موتورهای جستجو چگونه است؟

موتورهای جستجو کار کردن با اینترنت را بسیار آسان کردند آنها پایگاه بزرگ اطلاعاتی هستند ، که اطلاعات خود را از قبل آماده می کنند. و این گونه نیست كه درست در همان لحظه جستجو، تمام وب را بگردند . آنها اطلاعات مورد نیاز را قبلا" جمع آوری، تجزیه و تحلیل می كنند، آن را در پایگاه داده اش ذخیره می نماید و به هنگام جستجوی کاربر تنها در همین پایگاه داده می گردد. بخش های مجزای یك موتور جستجوگر عبارتند از:

- Spider یا عنکبوت

- Crawler یا خزنده

- Indexer یا بایگانی کننده

- Database یا پایگاه داده

- Ranker یا سیستم رتبه بندی

الف Spider- (عنکبوت)

اسپایدر یا روبوت (Robot)، اسپایدر به صفحات مختلف سر می زند، محتوای آنها را می خواند، لینکها را دنبال می کند، اطلاعات مورد نیاز را جمع آوری می كند و آن را در اختیار سایر بخش های موتور جستجوگر قرار می دهد. اسپایدر كدهای HTML صفحات را می بیند.

اسپایدر، به هنگام مشاهده صفحات، بر روی سرورها رد پا برجای می گذارد. شما اگر اجازه دسترسی به آمار دید و بازدیدهای صورت گرفته از یک سایت و اتفاقات انجام شده در آن را داشته باشید، می توانید مشخص كنید كه

اسپایدر كدام یک از موتورهای جستجوگر صفحات سایت را مورد بازدید قرار داده است. یکی از فعالیتهای اصلی که در SEM انجام می شود تحلیل آمار همین دید و بازدیدها است.

اسپایدرها كاربردهای دیگری نیز دارند، به عنوان مثال عده ای از آنها به سایت های مختلف مراجعه می كنند و فقط به بررسی فعال بودن لینك های آنها می پردازند و یا به دنبال آدرس ایمیل (Email) می گردند.

ب- Crawler (خزنده)

كراولر، نرم افزاری است كه به عنوان یك فرمانده برای اسپایدر عمل می كند. آن مشخص می كند که اسپایدر كدام صفحات را مورد بازدید قرار دهد. در واقع کراولر تصمیم می گیرد كه كدام یك از لینك های صفحه ای كه اسپایدر در حال حاضر در آن قرار دارد، دنبال شود. ممكن است همه آنها را دنبال كند، بعضی ها را دنبال كند و یا هیچ كدام را دنبال نكند.

کراولر، ممكن است قبلا" برنامه ریزی شده باشد که آدرس های خاصی را طبق برنامه، در اختیار اسپایدر قرار دهد تا از آنها دیدن کند. دنبال كردن لینك های یک صفحه به این بستگی دارد كه موتور جستجوگر چه حجمی از اطلاعات یک سایت را می تواند (می خواهد) در پایگاه داده اش ذخیره كند. همچنین ممكن است اجازه دسترسی به بعضی از صفحات به موتورهای جستجوگر داده نشده باشد.

ج- Indexer (بایگانی كننده)

تمام اطلاعات جمع آوری شده توسط اسپایدر در اختیار ایندکسر قرار می گیرد. در این بخش اطلاعات ارسالی مورد تجزیه و تحلیل قرار می گیرند و به بخش های متفاوتی تقسیم می شوند. تجزیه و تحلیل بدین معنی است كه مشخص می شود اطلاعات از كدام صفحه ارسال شده است، چه حجمی دارد، كلمات موجود در آن كدامند، و ... .

در حقیقت ایندکسر، صفحه را به پارامترهای آن خرد می کند و تمام این پارامترها را به یک مقیاس عددی تبدیل می کند تا سیستم رتبه بندی بتواند پارامترهای صفحات مختلف را با هم مقایسه کند. در زمان تجزیه و تحلیل اطلاعات، ایندکسر برای كاهش حجم داده ها از بعضی كلمات كه بسیار رایج هستند صرفنظر می کند. كلماتی نظیر a ، an ، the ، www ، is و ... . از این گونه كلمات هستند.

د - DataBase (پایگاه داده)

تمام داده های تجزیه و تحلیل شده در ایندکسر، به پایگاه داده ارسال می گردد. در این بخش داده ها گروه بندی، كدگذاری و ذخیره می شود. همچنین داده ها قبل از آنكه ذخیره شوند، طبق تکنیکهای خاصی فشرده می شوند تا حجم كمی از پایگاه داده را اشغال كنند. یك موتور جستجوگر باید پایگاده داده عظیمی داشته باشد و به طور مداوم حجم محتوای آن را گسترش دهد و البته اطلاعات قدیمی را هم به روز رسانی نماید. بزرگی و به روز بودن پایگاه داده یك موتور جستجوگر برای آن امتیاز محسوب می گردد. یكی از تفاوتهای اصلی موتورهای جستجوگر در حجم پایگاه داده آنها و همچنین روش ذخیره سازی داده ها در پایگاه داده است.

و- Ranker (سیستم رتبه بندی)

بعد از آنكه تمام مراحل قبل انجام شد، موتور جستجوگر آماده پاسخ گویی به سوالات كاربران است. كاربران چند كلمه را در جعبه جستجوی (Search Box) آن وارد می كنند و سپس با فشردن Enter منتظر پــاسخ می مانند. برای پاسخگویی به درخواست کاربر، ابتدا تمام صفحات موجود در پایگاه داده كه به موضوع جستجو شده، مرتبط هستند، مشخص می شوند. پس از آن سیستم رتبه بندی وارد عمل شده، آنها را از بیشترین ارتباط تا كمترین ارتباط مرتب می كند و به عنوان نتایج جستجو به كاربر نمایش می دهد.

حتی اگر موتور جستجوگر بهترین و كامل ترین پایگاه داده را داشته باشد اما نتواند پاسخ های مرتبطی را ارایه كند، یك موتور جستجوگر ضعیف خواهد بود. در حقیقت سیستم رتبه بندی قلب تپنده یك موتور جستجوگر است و تفاوت اصلی موتورهای جستجوگر در این بخش قرار دارد. سیستم رتبه بندی برای پاسخ گویی به سوالات كاربران، پارامترهای بسیاری را در نظر می گیرد تا بتواند بهترین پاسخ ها را در اختیار آنها قرار دارد.

حرفه ای های دنیای SEM به طور خلاصه از آن به Algo ( الگوریتم) یاد می كنند. الگوریتم، مجموعه ای از دستورالعمل ها است كه موتور جستجوگر با اعمال آنها بر پارامترهای صفحات موجود در پایگاه داده اش، تصمیم می گیرد که صفحات مرتبط را چگونه در نتایج جستجو مرتب كند. در حال حاضر قدرتمندترین سیستم رتبه بندی را گوگل در اختیار دارد.

معرفی انواع موتورهای جستجوگر در دنیا

موتورهای جستجو نقش بسیار مهمی در دنیای اینترنت و وب دارند، به طوری که اکثر افراد برای شروع به گشت و گذار در اینترنت با هدف دریافت اطلاعات، خرید محصولات و دریافت خدمات ابتدا یک عبارت را جستجو میکنند. ممکن است حتی چیزهای ساده مثل معنی یک کلمه، تاریخ اکران یک فیلم و... را نیز از موتورهای جستجو بپرسیم. شاید بدون موتورهای جستجو، پیدا کردن وبسایتهای مختلف در هر حوزهای کار بسیار دشواری بود.

از ابتدای ایجاد اینترنت و شبکه جهانی وب، شرکتهای بسیاری سعی کردند تا به بهترین شیوه نتایج مرتبط با جستجوی ما را نشان دهند. در ادامه با برخی از این موتورهای جستجو که بهترین عملکردها را دارند، آشنا خواهیم شد.

شاید نیازی به معرفی نباشد چون گوگل را همه میشناسند. گوگل جایگاه محبوبترین و مهمترین موتور جستجوی جهان را با خود یدک میکشد و حدود 90% درصد از جستجوهای اینترنتی از طریق گوگل انجام میشود. بر اساس امار ارائه شده از وبسایتهای Statista و statcounter گوگل در همه کشورها و در همه دستگاهها (موبایل، تبلت و دسکتاپ) بیشترین استفاده را در میان موتورهای جستجو دارد.

چیزی که گوگل را به محبوبترین و مورد اعتمادترین موتور جستجوی جهان تبدیل کرده است، کیفیت و مرتبط بودن نتایج جستجوی آن است. گوگل از یک الگوریتم بسیار پیچیده استفاده میکند تا مرتبطترین و دقیقترین نتایج را به کاربر نشان دهد.

بنیانگذاران گوگل یعنی لری پیج و سرگی برین این ایده را مطرح کردند که وبسایتهایی که از طریق سایر سایتها به آنها لینک داده میشود از اهمیت بیشتری برخوردار هستند و بنابراین باید در نتایج رتبه بهتری کسب کنند. در طول این سالها الگوریتمهای گوگل، صدها فاکتور رتبهبندی را معرفی کردهاند و هنوز هم قابل اطمینانترین ابزار برای پیدا کردن دقیق آنچه میخواهیم در اینترنت است.

مزایای گوگل:

- به تازگی محتوا اهمیت میدهد

- انواع محصولات، مقالات و خدمات را جستجو میکند

- در همه دستگاهها قابل استفاده است

- سریع و مرتبط است

- یکپارچگی با سایر ابزارهای گوگل

- قابلیت جستجوی تصاویر، نقشهها، ویدیوها و ...

معایب گوگل:

- جمعآوری اطلاعات از کاربران و استفاده از آنها

- نتایج بسیار زیاد که همگی مورد نیاز نیستند

Bing

طبق آمار ارائه شده در وبسایت Satista در ماه ژانویه 2022 حدود 7.6% از افراد از مایکروسافت بینگ استفاده میکنند. از نظر بسیاری از متخصصان، Microsoft Bing بهترین جایگزین برای گوگل است و حتی در برخی جنبهها از گوگل بهتر عمل میکند. Bing در نظر دارد جایگاه گوگل را به چالش بکشد اما بر خلاف این خواسته، هنوز نتوانسته کابران را متقاعد کند که به اندازه گوگل نتایج سریع و دقیقی ارائه میدهد.

با وجود اینکه سهم Bing نسبت به گوگل بسیار پایینتر است اما این سهم از اکتبر 2018 تا ژانویه 2022 پیوسته در حال افزایش بوده است و از 3.82% به 7.61 درصد رسیده است. ضمن این که Bing موتور جستجوی پیشفرض در دسکتاپهای ویندوزی است.

مزایای بینگ:

- به محتواهای قدیمی اما معتبر نیز اهمیت میدهد

- در همه دستگاهها قابل استفاده است

- انواع محصولات، مقالات و خدمات را جستجو میکند

- قابلیت جستجوی تصاویر، نقشهها، ویدیوها و ...

معایب بینگ:

- رتبه پایین انجمنها در نتایج

- سرعت جستجو کمی از گوگل پایینتر است

- برخی از صفحات تبلیغات زیادی دارند

Yahoo (یاهو)

یاهو یکی از محبوبترین ارائهدهندگان سرویس ایمیل است و موتور جستجوی آن رتبه سوم را از نظر میزان استفاده دارد و سهم 1 درصدی را از این بازار دارد، اما همین 1 درصد نیز آن را به یکی از پربازدیدترین وبسایتها در اینترنت تبدیل کرده است. سرویس موتور جستجوی یاهو در حال حاضر توسط Bing ارائه میشود. در سال های 2015 تا 2018 این سرویس توسط گوگل فراهم میشد. یاهو موتور جستجوی پیش فرض فایرفاکس در آمریکا است.

Yahoo علاوه بر سرویس جستجو، خدمات دیگری از جمله ایمیل، آب و هوا، نتایج ورزشهای مختلف، اخبار و... را نیز ارائه میدهد.

مزایای یاهو:

- جذابیت و ارائه اطلاعات مفید در برخی حوزهها مثل غذا

- ارائه خدمات متنوع آب و هوا و ...

معایب یاهو:

- سرویس جستجوی یاهو توسط بینگ ارائه میشود و مستقل نیست

- صفحه اصلی تبلیغات زیادی دارد

- تفاوت تبلیغات و جستجوی ارگانیک واضح نیست

- جمعآوری اطلاعات از کاربران

- صفحه اصلی شلوغ و نامنظم است

Baidu

Baidu بزرگترین موتور جستجوی کشور چین است که به معنی دسترسی به یک بازار بسیار بزرگ است. سهم Baidu از بازار جستجوی چین حدود 70 درصد است یعنی حتی بیشتر از گوگل، بنابراین رکورد بیشترین کاربران یک موتور جستجو در یک کشور را دارد.

مانند گوگل، Baidu هم از ریچاسنیپتهای خاص خود برخوردار است که استفاده از آن را بسیار آسان میکند. بزرگترین مشکل Baidu این است که بیشتر بر بازار چین متمرکز شده است بنابراین اگر کسبوکار شما در چین نیست، ممکن است برای شما مناسب نباشد.

مزایای Baidu:

- ویژگیهای پیشرفته مثل ریچ اسنیپت

- بهترین روش برای حضور در بازار چین

- طراحی ساده و سرعت بالای جستجو

معایب Baidu:

- سانسور شدید: Baidu به هر محتوایی اجازه انتشار نمیدهد

- در نظر نگرفتن بازار جهانی

- عملکرد ضعیفتر برای زبانهای غیر چینی

AOL

AOL یک موتور جستجوی آمریکایی است که در ماه حدود 1.5 میلیون کاربر یکتا دارد. شرکت AOL در واقع یکی از شرکتهای ارائهدهنده خدمات اینترنت و تبلیغات است که در دهه 90 یکی از شناختهشدهترین برندها در حوزه اینترنت بود. از آنجایی که بخش عمده سهام AOL توسط یاهو خریداری شد، نتایج این موتور جستجو نیز توسط Bing ارائه میشود.

مزایای AOL:

- پاسخگویی مناسب به سؤالات مستقیم (مثلاً آب و هوا در تهران چگونه است؟)

- جستجوی عکس، ویدیو و ...

معایب AOL:

- اطلاعات و تبلیغات بیش از حد در صفحه اصلی

- نتایج بعضاً غیرمرتبط با نیت کاربر

- عدم نمایش تاریخ انتشار نتایج

Ask.com

Ask.com یک موتور جستجو است که در سال 1996 در آمریکا شروع به کار کرد. در ابتدا Ask.com تنها به عنوان یک ماشین پاسخگو شناخته میشد که هدف آن ارائه پاسخ مستقیم به پرسشهای کاربران بود و البته هنوز هم یکی از اهداف مهم آن محسوب میشود. بازدید ماهانه این موتور جستجو حدود 40 میلیون است. ناگفته نماند که Ask دارای دیتابیس و الگوریتمهای خاص خودش است و بر خلاف AOL و یاهو از موتورهای جستجوی دیگر کمک نمیگیرد.

مزایای Ask.com

- الگوریتم آن تخصص را بر محبوبیت سایتها ترجیح میدهد

- توانایی جستجو در لغتنامهها، دانشنامهها و ... مثل ویکیپدیا

- نشان دادن پیشنمایش وبسایتها قبل از بازدید آن

- ارائه کلمات کلیدی مرتبط و داشتن برخی اسنیپتها

معایب Ask.com

- صفحه اصلی دارای تبلیغات و اطلاعات زیادی است

- نتایج دقیقی را برای همه کلمات نشان نمیدهد

- تبلیغات زیاد در صفحه نتایج

عالي بود.